Speech SDK を使用して音声認識してみる

こんばんは。

ふとTVをつけたら深キョンがドラマに出てて、可愛すぎてブログ書くのをやめようかと思いましたw僕です。

駆け出しMacユーザーの僕ですが、毎日少しずつでもMac触っていたら、思ったより使い勝手がいい事に最近気づき始めた次第です。

昨日の夜、久々にSurfaceで作業してたら、今まで普通に使ってたタイプカバーのタッチパッドは思ってたよりも小さくて驚きましたw

さて、今日はCognitive Servicesの一つである「Speech Service」を使ってみます。

前々から気にはなっていたのですが、日本語で音声認識なんて正直期待出来ないイメージが強いので手付かずのままだったのですが、触ってもないのに使えなさそーはないだろうと思い今回に至ります。

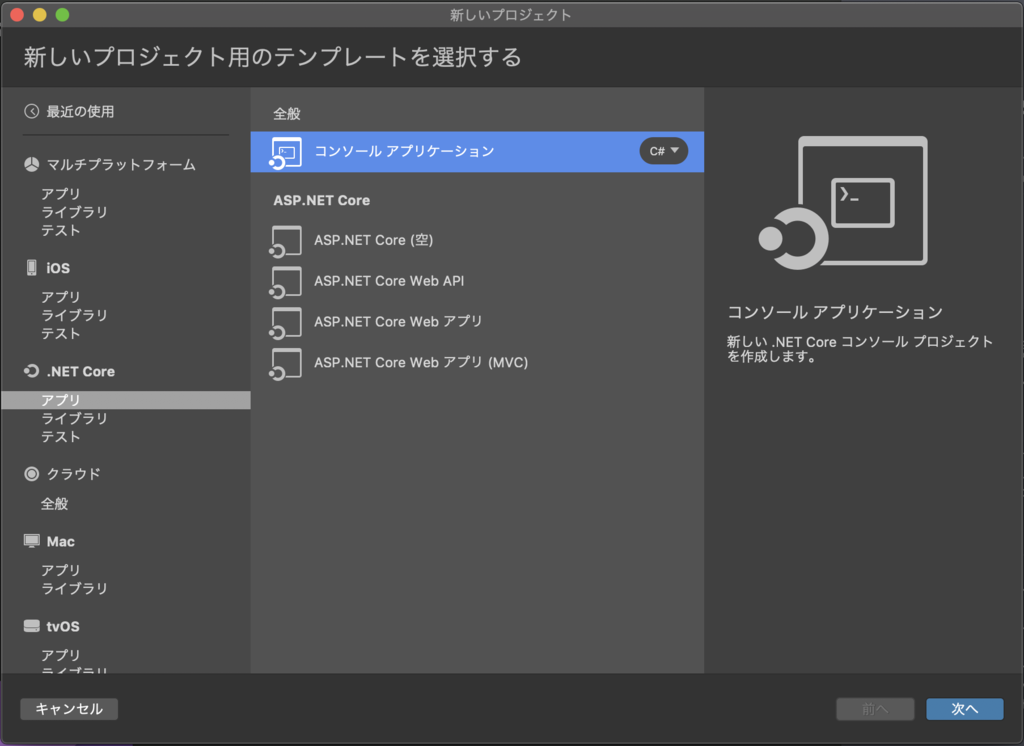

Pjtを作成します。

今回は.NET Coreを使ってコンソールアプリケーションを作成します。

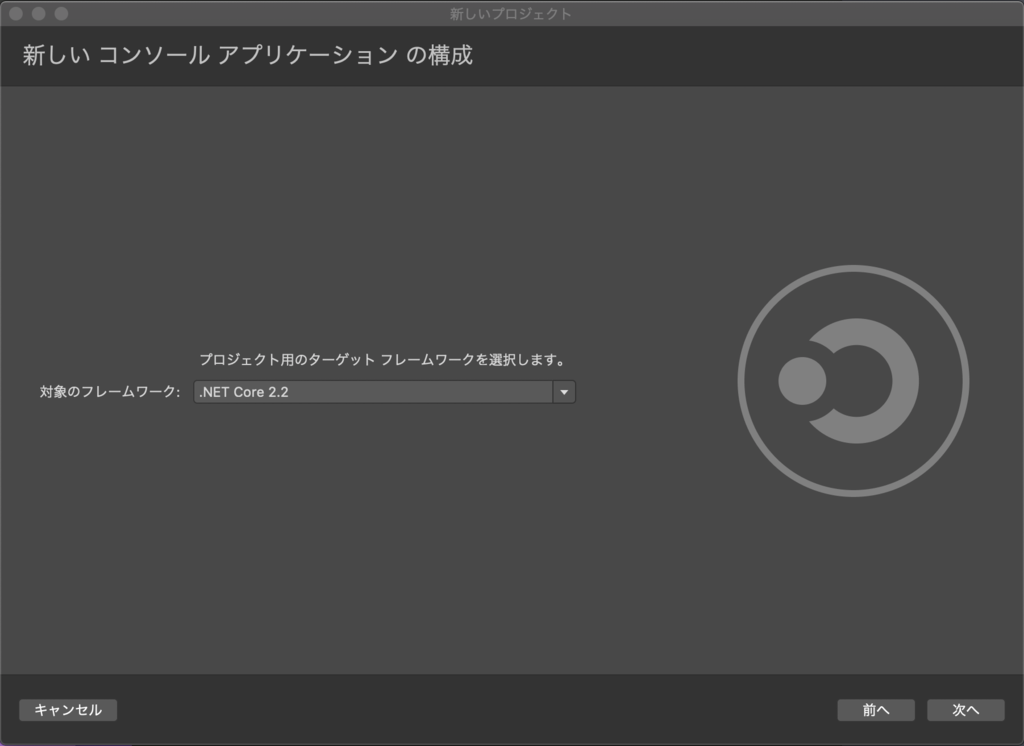

先月GAされた.NET Core 2.2を選択

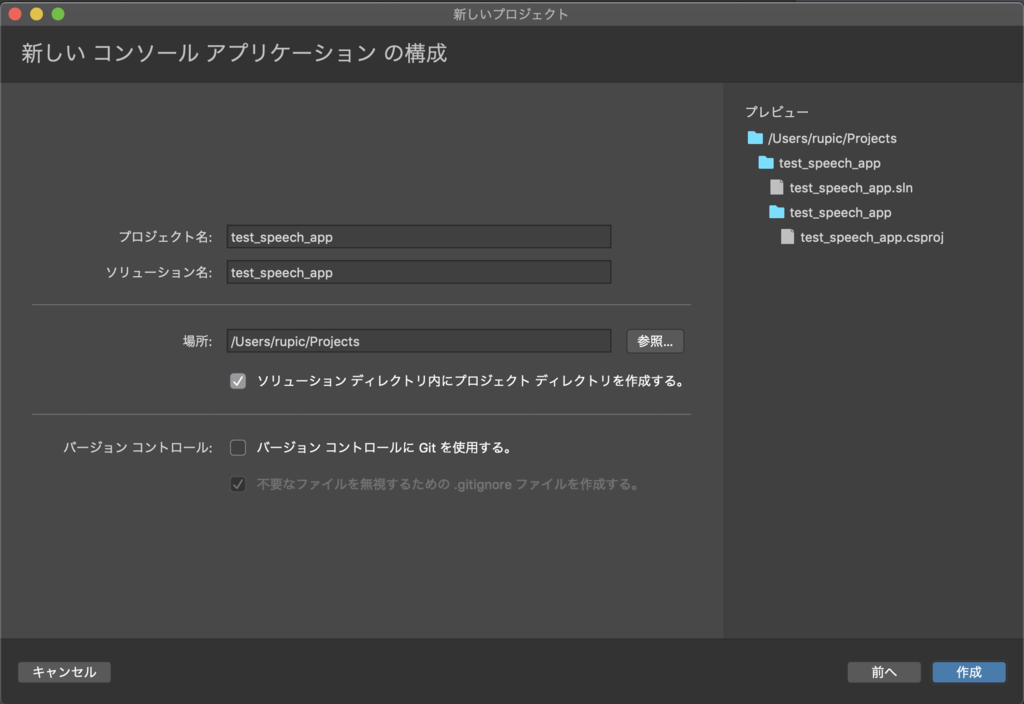

適当に名前をつけてプロジェクトを作成しましょう

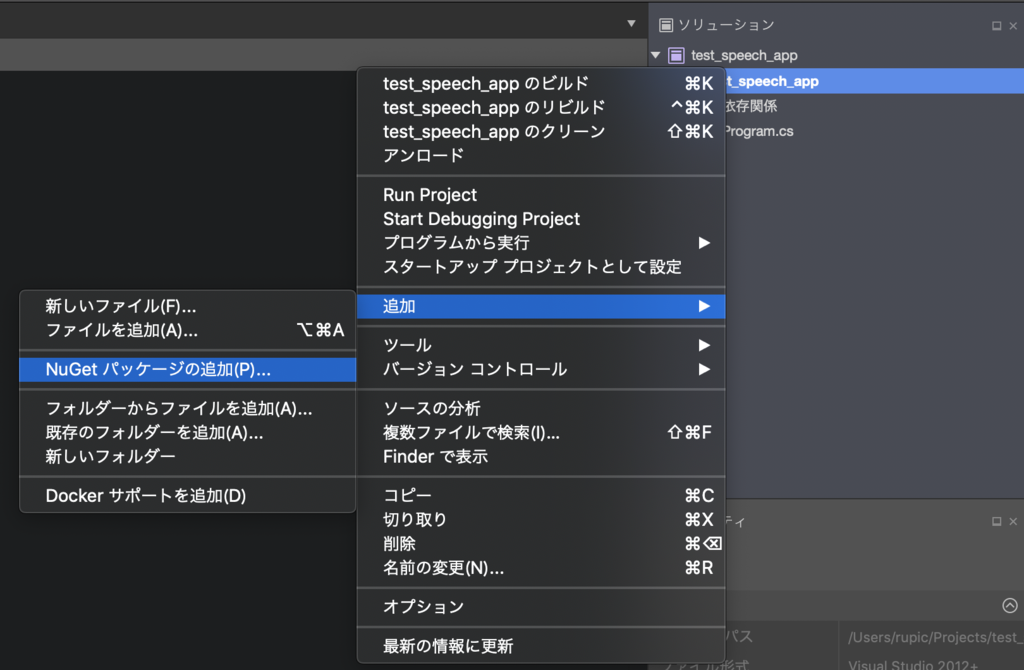

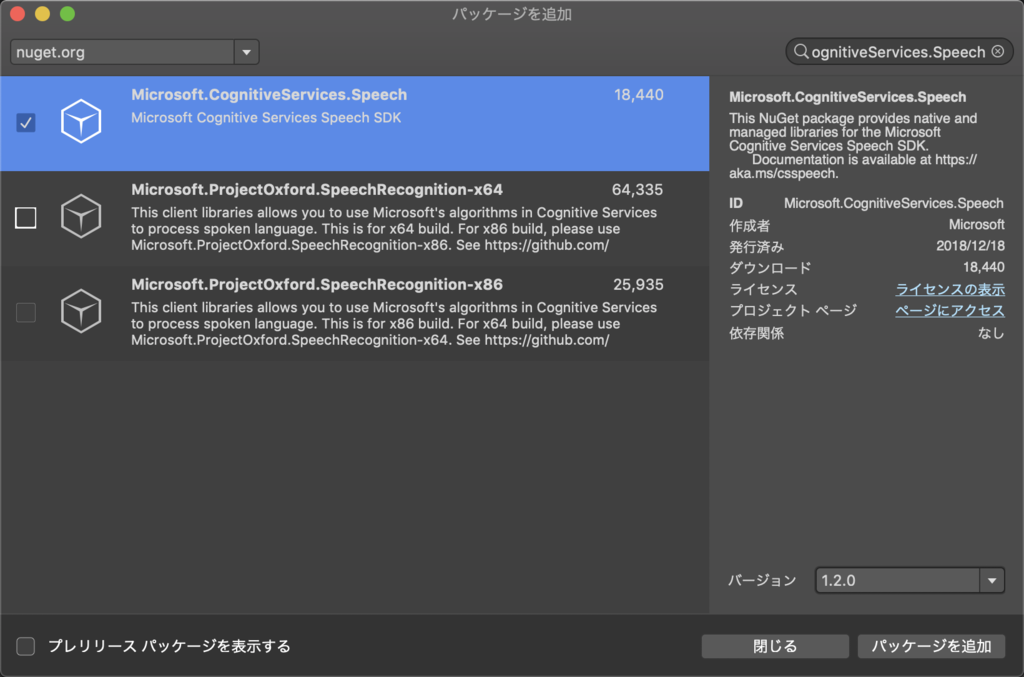

プロジェクトを追加したらNugetの追加から以下のパッケージをインストールします

「Microsoft.CognitiveServices.Speech」

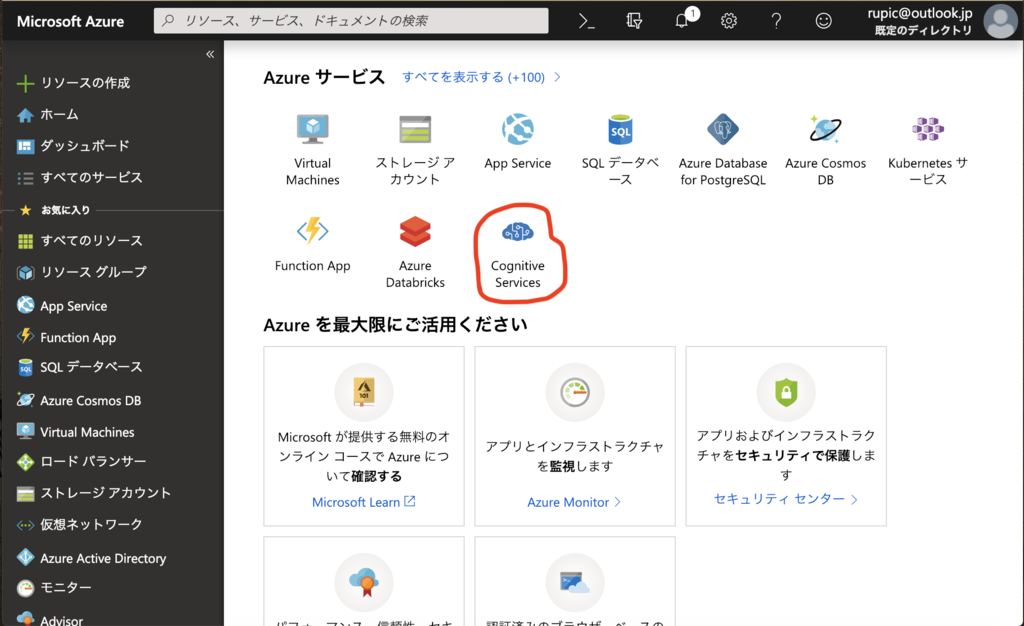

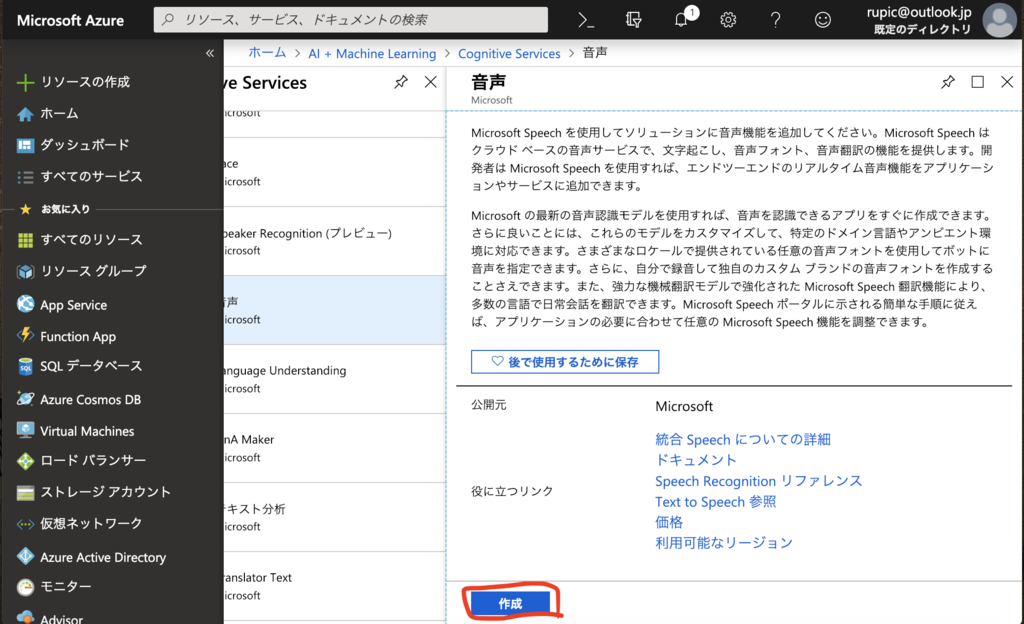

AzureポータルでCognitive Servicesを選択

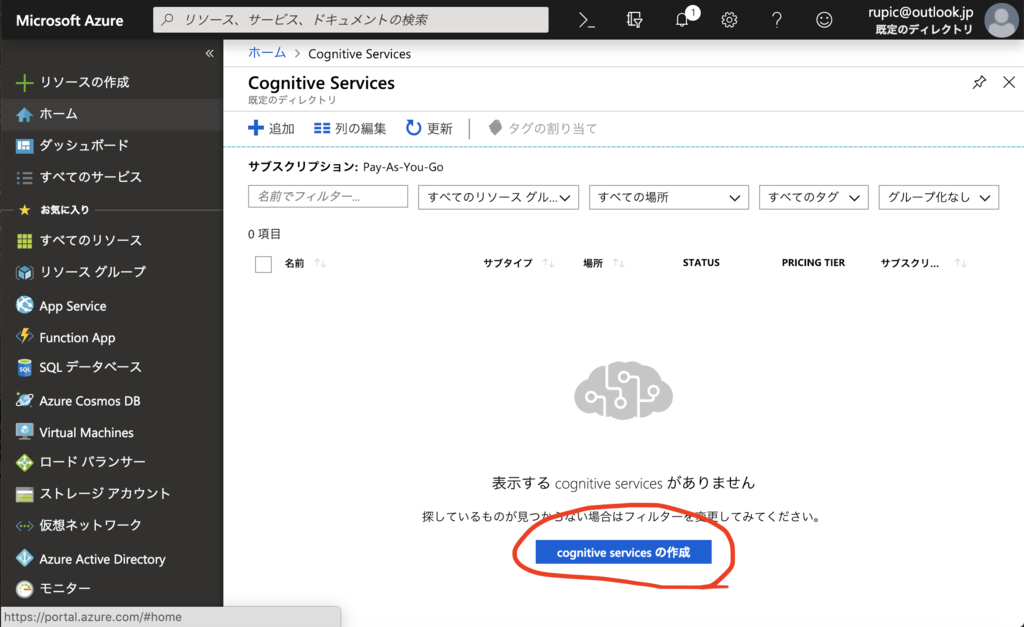

CognitiveServicesの一覧を表示するためには右側の「さらに表示」をクリック

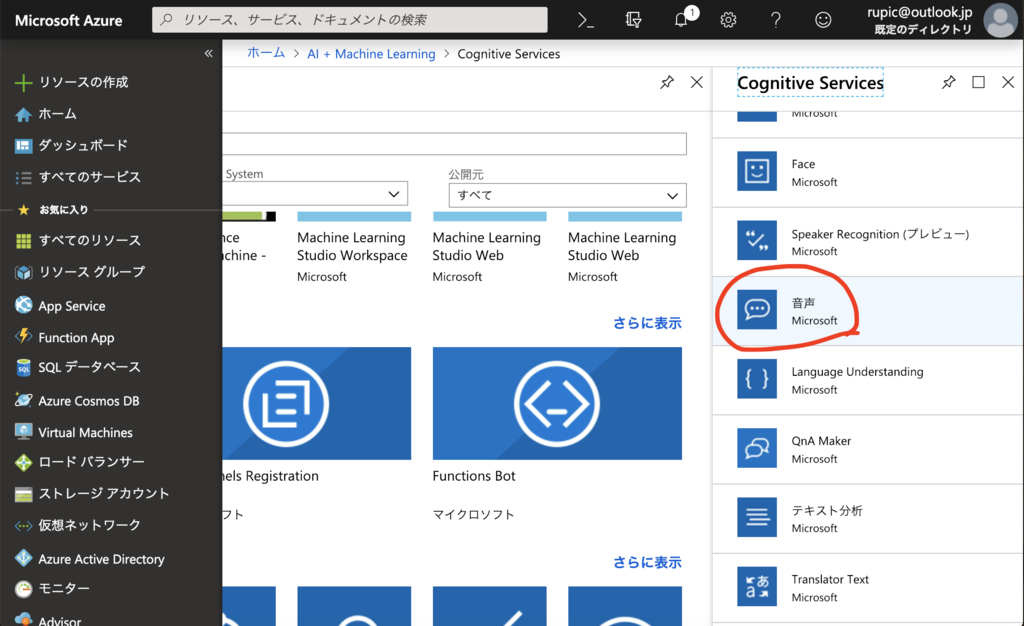

音声を選択します

作成をクリック

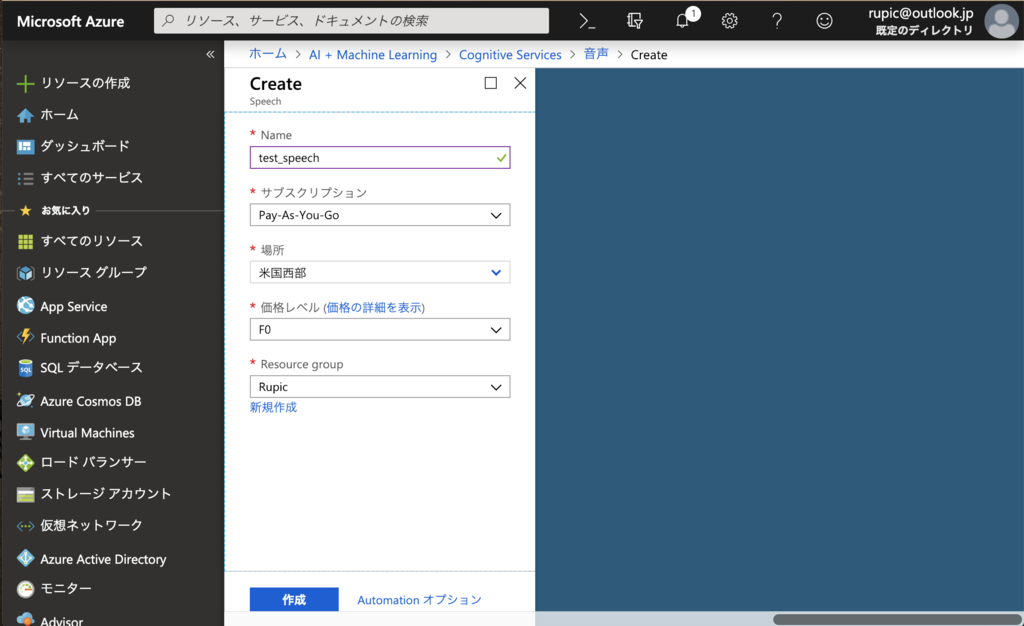

これもいつもな感じですねw

適当に名前をつけてリージョンやリソースグループを選択しデプロイします

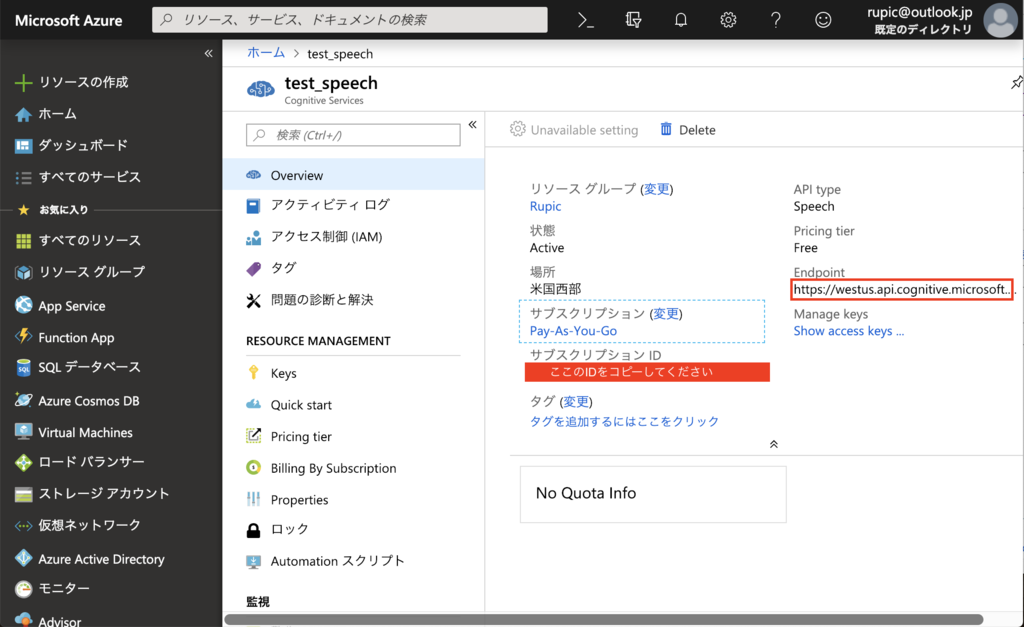

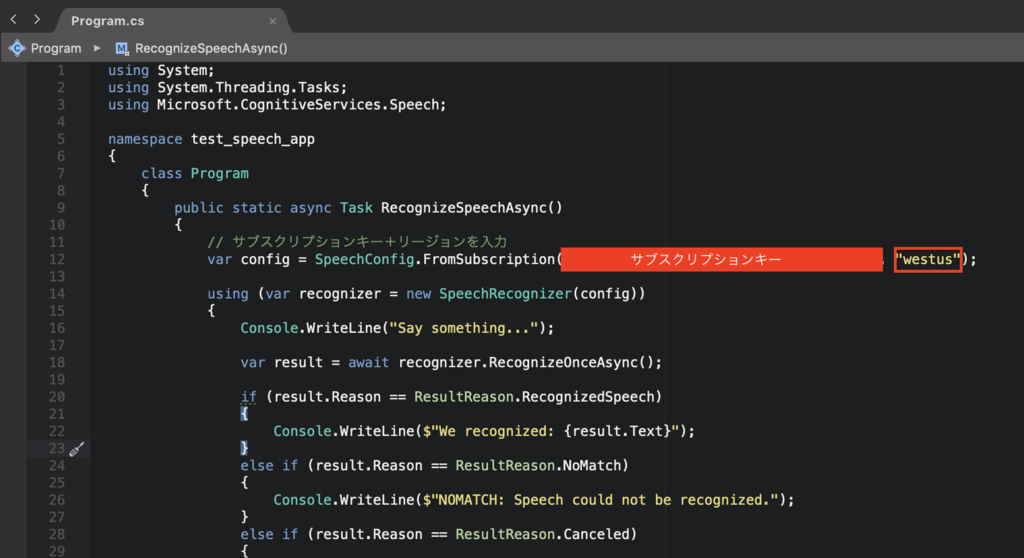

数分後、デプロイが完了するのでサブスクリプションキーとリージョンをソースに貼り付けます。

こんな感じw

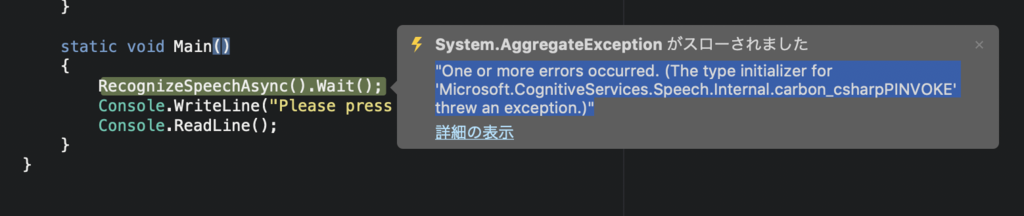

ここまできたらとりあえず、再生してみましょう!!!!

あら…。。。

"One or more errors occurred. (The type initializer for 'Microsoft.CognitiveServices.Speech.Internal.carbon_csharpPINVOKE' threw an exception.)"

とエラーが出てうまく動きません。。

マイクをPC内蔵のもので動作させたからかと思い色々調べてみたところ、

以下の記事を見つけましたw

あーMacでSpeech SDK対応してないんですって(T ^ T)

今度時間がある時にWindowsで試してみるかなw

残念。。